Nova safra de ferramentas de Inteligência Artificial (IA) oferece a capacidade de gerar textos atraentes, imagens realistas e, cada vez mais, vídeos e áudios

No mês passado, um vídeo postado no Twitter pela campanha presidencial do governador da Flórida, Ron DeSantis, usou imagens que pareciam ser geradas por inteligência artificial mostrando o ex-presidente Donald Trump abraçando o Dr. Anthony Fauci. As imagens, que pareciam destinadas a criticar Trump por não demitir o principal especialista em doenças infecciosas do país, eram difíceis de detectar: eram mostradas ao lado de imagens reais do par e com uma sobreposição de texto dizendo: “Trump da vida real”.

À medida que as imagens começaram a se espalhar, organizações de verificação de fatos e usuários atentos rapidamente as sinalizaram como falsas. Mas o Twitter, que cortou grande parte de sua equipe nos últimos meses sob nova propriedade, não removeu o vídeo. Em vez disso, acabou adicionando uma nota da comunidade – um recurso liderado por contribuidores para destacar desinformação na plataforma de mídia social – à postagem, alertando os usuários do site de que no vídeo “3 fotos mostrando Trump abraçando Fauci são imagens geradas por IA”.

Especialistas em integridade de informações digitais dizem que é apenas o começo do uso de conteúdo gerado por IA antes da eleição presidencial dos EUA em 2024 de maneiras que podem confundir ou enganar os eleitores.

Uma nova safra de ferramentas de IA oferece a capacidade de gerar texto atraente e imagens realistas – e, cada vez mais, vídeo e áudio. Especialistas e até mesmo alguns executivos que supervisionam empresas de IA dizem que essas ferramentas correm o risco de espalhar informações falsas para enganar os eleitores, inclusive antes das eleições de 2024 nos EUA.

“As campanhas estão começando a crescer, as eleições estão chegando rapidamente e a tecnologia está melhorando rapidamente”, disse Jevin West, professor da Universidade de Washington e cofundador do Center for an Informed Public. “Já vimos evidências do impacto que a IA pode ter.”

As empresas de mídia social têm uma responsabilidade significativa em lidar com esses riscos, dizem os especialistas, como as plataformas onde bilhões de pessoas vão em busca de informações e onde os malfeitores frequentemente vão para espalhar falsas alegações. Mas agora eles enfrentam uma tempestade perfeita de fatores que podem tornar mais difícil do que nunca acompanhar a próxima onda de desinformação eleitoral.

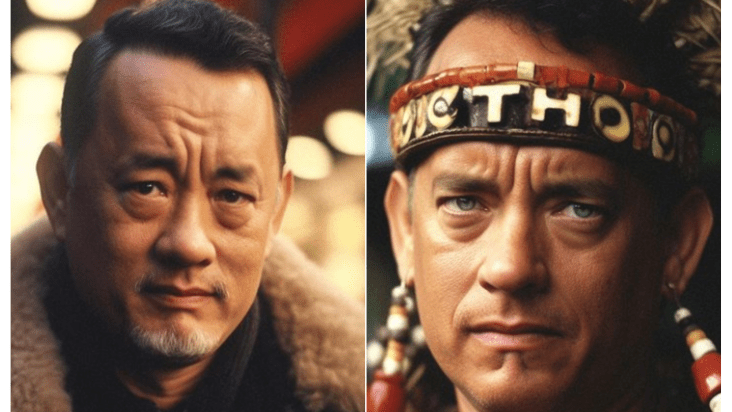

Fotos: Inteligência artificial recria famosos

Fonte: Crédito: Reprodução/Instagram

Um perfil no Instagram criou variações de algumas personalidades internacionais. Na lista, Mark Zuckerberg aparece como um homem negro, albino e também robô

Fonte: Crédito: Reprodução/Instagram

Trump também foi recriado pela inteligência

Fonte: Crédito: Reprodução/Instagram

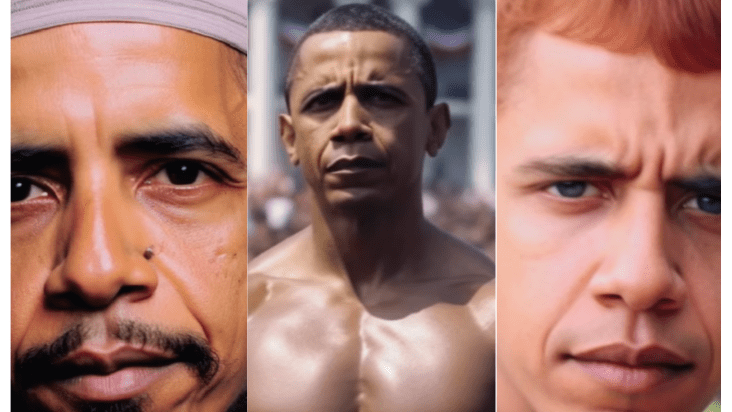

Também é possível ver as projeções de Barack Obama. Algumas imagens o monstram com o físico delineado, como homem ruivo e ainda muçulmano

Fonte: Crédito: Reprodução/Instagram

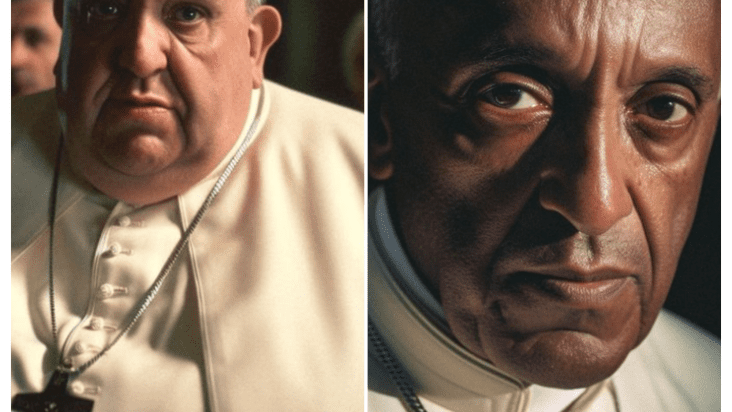

O Papa Francisco não ficou de fora. A inteligência mostrou o pontífice com sobrepeso, além de homem negro

Fonte: Crédito: Reprodução/Instagram

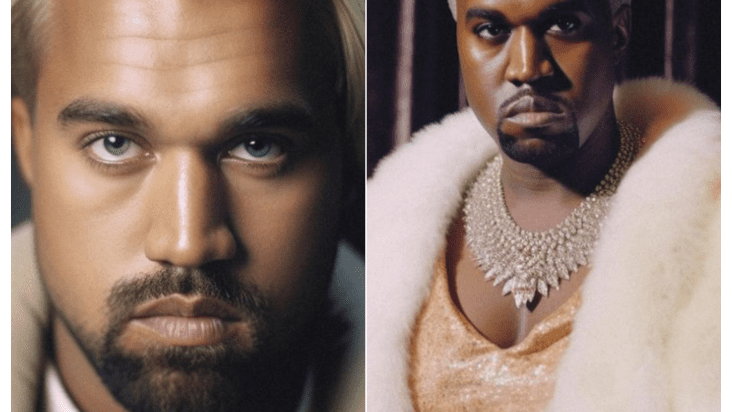

Já o rapper Kanye West foi exibido com os olhos azuis e também com trajes femininos

Fonte: Crédito: Reprodução/Instagram

O rapper Snoop Dogg também apareceu de olhos claros e como se fosse um cão

Fonte: Crédito: Reprodução/Instagram

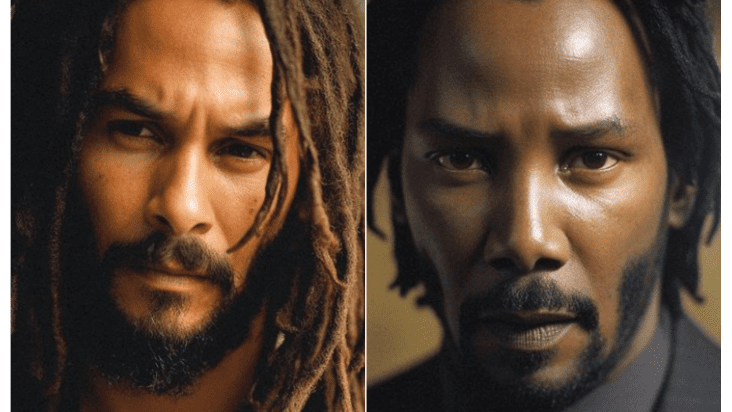

O ator Keanu Reeves, de filmes como “Matrix” e “Constantine” foi projetado com dreads no cabelo, além da pele negra

Fonte: Crédito: Reprodução/Instagram

O ator Tom Hanks apareceu como traços orientais, além de vestimentas de povos originários

Várias grandes redes sociais recuaram na aplicação de algumas desinformações relacionadas às eleições e sofreram demissões significativas nos últimos seis meses, que em alguns casos atingiram a integridade eleitoral , a segurança e as equipes de IA responsáveis . Funcionários atuais e anteriores dos EUA também alertaram que a decisão de um juiz federal no início deste mês de limitar a forma como algumas agências dos EUA se comunicam com empresas de mídia social pode ter um “efeito inibidor” sobre como o governo federal e os estados lidam com a desinformação relacionada às eleições. (Na sexta-feira, um tribunal de apelações bloqueou temporariamente a ordem.)

Enquanto isso, a IA está evoluindo em um ritmo acelerado. E, apesar dos apelos de participantes do setor e outros, os legisladores e reguladores dos EUA ainda não implementaram barreiras reais para tecnologias de IA.

“Não estou confiante nem mesmo na capacidade deles de lidar com os tipos antigos de ameaças”, disse David Evan Harris , pesquisador de IA e consultor de ética do Instituto de Psicologia da Tecnologia, que trabalhou anteriormente com IA responsável na Meta, controladora do Facebook. “E agora há novas ameaças.”

As principais plataformas disseram à CNN que possuem políticas e práticas existentes relacionadas à desinformação e, em alguns casos, visando especificamente conteúdo “sintético” ou gerado por computador, que, segundo eles, os ajudará a identificar e lidar com qualquer desinformação gerada por IA. Nenhuma das empresas concordou em disponibilizar para uma entrevista alguém que trabalha em esforços de detecção de IA generativa.

As plataformas “não estavam prontas no passado e não há absolutamente nenhuma razão para acreditarmos que estarão prontas agora”, disse Bhaskar Chakravorti, reitor de negócios globais da The Fletcher School da Tufts University, à CNN.

‘Ameaçando nossa capacidade de distinguir fato de ficção’

Conteúdo enganoso, especialmente relacionado a eleições, não é novidade. Mas com a ajuda da inteligência artificial, agora é possível para qualquer pessoa criar grandes quantidades de conteúdo falso de forma rápida, fácil e barata.

E, dada a rápida melhoria da tecnologia de IA no ano passado, é provável que imagens, textos, áudios e vídeos falsos sejam ainda mais difíceis de discernir quando as eleições dos EUA acontecerem no ano que vem.

“Ainda temos mais de um ano até a eleição. Essas ferramentas vão melhorar e, nas mãos de usuários sofisticados, podem ser muito poderosas”, disse Harris . Ele acrescentou que os tipos de desinformação e interferência eleitoral que ocorreram nas mídias sociais em 2016 e 2020 provavelmente só serão exacerbados pela IA.

As várias formas de conteúdo gerado por IA podem ser usadas juntas para tornar as informações falsas mais críveis – por exemplo, um artigo falso escrito por IA acompanhado por uma foto gerada por IA com o objetivo de mostrar o que aconteceu no relatório, disse Margaret Mitchell, pesquisadora e cientista-chefe de ética da empresa de IA de código aberto Hugging Face.

As ferramentas de IA podem ser úteis para qualquer pessoa que queira enganar, mas especialmente para grupos organizados e adversários estrangeiros incentivados a se intrometer nas eleições dos EUA. Enormes fazendas de trolls estrangeiros foram contratadas para tentar influenciar eleições anteriores nos Estados Unidos e em outros lugares, mas “agora, uma pessoa pode ser encarregada de implantar milhares de milhares de bots de IA generativos que funcionam”, para distribuir conteúdo nas mídias sociais para enganar os eleitores, disse Mitchell, que trabalhou anteriormente no Google.

A OpenAI , criadora do popular chatbot de IA ChatGPT, emitiu um alerta severo sobre o risco de desinformação gerada por IA em um recente trabalho de pesquisa . Uma abundância de informações falsas de sistemas de IA, sejam intencionais ou criadas por preconceitos ou “alucinações” dos sistemas, tem “o potencial de lançar dúvidas sobre todo o ambiente de informações, ameaçando nossa capacidade de distinguir fato de ficção”, afirmou.

Exemplos de desinformação gerada por IA já começaram a surgir. Em maio, várias contas do Twitter, incluindo algumas que pagaram por uma marca de verificação azul de “verificação”, compartilharam imagens falsas que pretendiam mostrar uma explosão perto do Pentágono. Embora as imagens tenham sido rapidamente desmascaradas, sua circulação foi brevemente seguida por uma queda no mercado de ações. O Twitter suspendeu pelo menos uma das contas responsáveis pela divulgação das imagens. O Facebook rotulou postagens sobre as imagens como “informações falsas”, juntamente com uma verificação de fatos.

Um mês antes, o Comitê Nacional Republicano divulgou um anúncio de 30 segundos em resposta ao anúncio oficial da campanha do presidente Joe Biden, que usava imagens de IA para imaginar um Estados Unidos distópico após a reeleição do 46º presidente. O anúncio da RNC incluía o pequeno aviso na tela, “Construído inteiramente com imagens de IA”, mas alguns eleitores em potencial em Washington DC a quem a CNN mostrou o vídeo não o identificaram na primeira exibição.

Dezenas de legisladores democratas enviaram na semana passada uma carta pedindo à Comissão Eleitoral Federal que considere reprimir o uso de tecnologia de inteligência artificial em anúncios políticos, alertando que anúncios enganosos podem prejudicar a integridade das eleições do ano que vem.

Proteção contra desinformação gerada por IA

Antes de 2024, muitas das plataformas disseram que lançarão planos para proteger a integridade da eleição, inclusive da ameaça de conteúdo gerado por IA.

No início deste ano, o TikTok lançou uma política estipulando que a mídia “sintética” ou manipulada criada pela IA deve ser claramente rotulada, além de sua política de integridade cívica que proíbe informações enganosas sobre processos eleitorais e sua política geral de desinformação que proíbe alegações falsas ou enganosas que podem causar “danos significativos” a indivíduos ou à sociedade.

O YouTube tem uma política de mídia manipulada que proíbe o conteúdo que foi “manipulado ou adulterado” de forma que possa enganar os usuários e “possam representar um sério risco de danos flagrantes”. A plataforma também possui políticas contra conteúdo que possa enganar os usuários sobre como e quando votar, alegações falsas que possam desencorajar a votação e conteúdo que “incentiva outras pessoas a interferir nos processos democráticos”. O YouTube também afirma que destaca notícias e informações confiáveis sobre eleições em sua plataforma e que sua equipe focada nas eleições inclui membros de suas equipes de confiança e segurança, produto e “Mesa de Inteligência”.

“Conteúdo manipulado tecnicamente, incluindo conteúdo eleitoral, que engana os usuários e pode representar um sério risco de dano flagrante não é permitido no YouTube”, disse o porta-voz do YouTube, Ivy Choi, em um comunicado. “Aplicamos nossa política de conteúdo manipulado usando aprendizado de máquina e revisão humana e continuamos a melhorar esse trabalho para ficar à frente de possíveis ameaças.”

Um porta-voz da Meta disse à CNN que as políticas da empresa se aplicam a todo o conteúdo de suas plataformas, incluindo conteúdo gerado por IA. Isso inclui sua política de desinformação , que estipula que a plataforma remova alegações falsas que possam “contribuir diretamente para a interferência no funcionamento de processos políticos e de certas mídias manipuladas altamente enganosas” e pode reduzir a disseminação de outras alegações enganosas. A Meta também proíbe anúncios com conteúdo que foi desmascarado por sua rede de verificadores de fatos terceirizados.

TikTok e Meta também se juntaram a um grupo de parceiros da indústria de tecnologia coordenados pela Partnership on AI, sem fins lucrativos, dedicada ao desenvolvimento de uma estrutura para o uso responsável de mídia sintética.

Solicitado a comentar esta história, o Twitter respondeu com uma resposta automática de um emoji de cocô.

O Twitter reverteu grande parte de sua moderação de conteúdo nos meses desde que o bilionário Elon Musk assumiu a plataforma e, em vez disso, se apoiou mais fortemente em seu recurso “Notas da comunidade”, que permite aos usuários criticar a precisão e adicionar contexto às postagens de outras pessoas. Em seu site, o Twitter também diz que tem uma política de “mídia sintética” sob a qual pode rotular ou remover “mídia sintética, manipulada ou fora de contexto que pode enganar ou confundir as pessoas e causar danos”.

Ainda assim, como costuma acontecer com as mídias sociais, o desafio provavelmente será menos uma questão de implementar as políticas do que aplicá-las. As plataformas usam amplamente uma mistura de revisão humana e automatizada para identificar desinformação e mídia manipulada. As empresas se recusaram a fornecer detalhes adicionais sobre seus processos de detecção de IA, incluindo quantos funcionários estão envolvidos em tais esforços.

Mas especialistas em IA dizem estar preocupados que os sistemas de detecção de conteúdo gerado por computador das plataformas possam ter dificuldade em acompanhar os avanços da tecnologia. Mesmo algumas das empresas que desenvolvem novas ferramentas de IA generativas têm lutado para criar serviços que possam detectar com precisão quando algo é gerado por IA.

Alguns especialistas estão pedindo a todas as plataformas sociais que implementem políticas que exijam que o conteúdo gerado ou manipulado por IA seja claramente rotulado e pedindo aos reguladores e legisladores que estabeleçam barreiras em torno da IA e responsabilizem as empresas de tecnologia pela disseminação de falsas alegações.

Uma coisa é certa: as apostas para o sucesso são altas. Especialistas dizem que não apenas o conteúdo gerado por IA cria o risco de os usuários da Internet serem enganados por informações falsas; também pode tornar mais difícil para eles confiar em informações reais sobre tudo, desde votação até situações de crise.

“Sabemos que estamos entrando em uma situação muito assustadora, onde não ficará muito claro o que aconteceu e o que realmente não aconteceu”, disse Mitchell. “Destrói completamente a base da realidade quando se trata de saber se o conteúdo que você está vendo é real ou não.”

Fonte:

https://www.cnnbrasil.com.br/tecnologia/com-o-surgimento-da-ia-plataformas-sociais-podem-enfrentar-uma-tempestade-de-desinformacao-em-2024/